ritorno a corrierebit - scienza

La

Radiazione Cosmica di Fondo di

Marco A.C. Potenza e M.G Giammarchi

Sappiamo

che quando osserviamo oggetti celesti lontani, a causa della velocità finita di

propagazione della luce, li osserviamo come erano nel momento in cui hanno

emesso la luce: al crescere della loro distanza da noi, quindi, osserviamo

oggetti sempre più “giovani”, che hanno emesso radiazione in tempi sempre

più lontani nel passato. Sebbene il non poter vedere l’Universo come si

presenta oggi possa sembrare limitante, ad un’analisi più approfondita questa

si rivela come una grande opportunità per gli astronomi. Se guardiamo la

galassia di Andromeda ad esempio,

che dista da noi 2.7 milioni di anni luce, riveliamo la luce emessa 2.7 milioni

di anni fa, quando la galassia era in una condizione simile a quella in cui si

trova oggi (qualche milione di anni è ancora un tempo breve sulla scala

cosmica). Ma con l’impiego dei telescopi più potenti (per non parlare del

Telescopio Spaziale Hubble) ci siamo spinti ad osservare galassie a miliardi di

anni luce di distanza, galassie giovani, che magari non hanno ancora terminato

la loro formazione. Ecco quindi che la velocità finita della luce si trasforma

in uno “strumento” per osservare l’Universo come era nel passato. Ma

quanto possiamo andare indietro nel tempo ad indagare l’Universo? Rispondere a

questa domanda non è facile: è necessario uno sguardo alla moderna cosmologia

per capire cosa accade, almeno in linea di principio, quando si getti lo sguardo

sempre più lontano, sempre più indietro nel tempo, lungo la storia

dell’evoluzione cosmica. E curiosamente scopriamo che il percorso che fornisce

risposte a queste domande è lo stesso che hanno seguito i cosmologi nel

ventesimo secolo durante la loro attività di ricerca, e che ha portato ai

lavori per i quali è stato assegnato il Premio Nobel di quest’anno. La

cosmologia, dal greco κόσμος

e λόγος

, si riferisce allo studio del Cosmo inteso come un tutto, della totalità di ciò

che esiste nell’Universo; è chiaro che la definizione è un po’ ingenua,

poiché per descrivere il “tutto” è necessario conoscerlo, e la conoscenza

dell’Universo cambia e aumenta costantemente con il proseguire delle

osservazioni e degli studi teorici. Questo comporta che in qualsiasi momento la

descrizione del ”tutto” sarà destinata a venire successivamente completata

in base alle nuove scoperte. Solo dagli inizi del ventesimo secolo la Cosmologia

ha cominciato a svilupparsi secondo i paradigmi del metodo scientifico, per cui

ancora oggi risulta una scienza relativamente “nuova”. Le fondamenta di

questa scienza sono profondamente legate alla teoria della Relatività Generale

di Einstein, pubblicata nel 1915, rivolta alla descrizione delle interazioni

gravitazionali in maniera del tutto nuova e più completa rispetto alla teoria

di Newton. Pochi anni dopo sia Einstein che Friedmann applicarono la nuova

Teoria della gravitazione alla descrizione dell’Universo, scoprendo che era in

contrasto con la visione del tempo che vedeva l’Universo come una entità

statica e immutabile. Purtroppo però Einstein rinunciò a sviluppare questa

teoria e il lavoro di Friedmann, che invece gli aveva dato pieno credito minando

l’ipotesi statica, rimase nell’oblio fino al 1935. Nel frattempo un giovane

astronomo avrebbe dato inizio alla Cosmologia osservativa in maniera del tutto

inattesa.

La

legge di Hubble

La

nascita della Cosmologia osservativa si può far risalire alla scoperta,

effettuata da Hubble nel 1929, secondo la quale più un oggetto è distante da

noi più esso si allontana velocemente. La relazione, detta Legge di Hubble, che

sussiste tra distanza e velocità di allontanamento è una semplice relazione di

proporzionalità: se ad esempio un oggetto dista il doppio di un altro da noi,

allora si allontana da noi con una velocità due volte superiore. A prima vista

questa legge sembrerebbe implicare che la nostra posizione nell'Universo sia

privilegiata, nel senso che noi abbiamo l’impressione di trovarci situati al

centro di questo fenomeno di espansione. In realtà è sufficiente un semplice

paragone per capire che invece non è cosi. Per esempio consideriamo un

palloncino che si gonfia: tutti i punti della sua superficie si allontanano

l'uno dall'altro e la velocità di allontanamento cresce al crescere della

distanza (misurata lungo la superficie). In questa analogia la superficie del

palloncino rappresenta lo spazio ordinario a tre dimensioni. Mentre nel caso del

palloncino l’espansione avviene in tre dimensioni (solo due delle quali

vengono percepite dagli abitanti della superifice del palloncino) nel nostro

caso l'espansione avviene in uno

spazio a quattro. La legge di Hubble mostra quindi che l'Universo è in

espansione ed è inoltre possibile dimostrare che tutti i suoi punti sono

equivalenti, ossia che la legge sarebbe la stessa se le osservazioni venissero

compiute in luoghi differenti. Un’altra precisazione utile riguarda il

fatto che questa legge di espansione è di tipo cosmologico e quindi riguarda

delle distanze cosiddette cosmologiche. Queste sono le enormi distanze che

separano gli ammassi di galassie; per distanze piu’ piccole l’effetto della

Legge di Hubble è oscurato dall’azione dei moti gravitazionali “locali”.

Si suole quindi dire che questa legge (come peraltro gran parte della

Cosmologia) si applica all’Universo visto su grandi scale.

L'ipotesi

del Big Bang

Se

è in atto un'espansione, vi dovrà necessariamente essere stato un momento

nel passato in cui tutto l'Universo era concentrato in una regione molto

piccola, dalla quale si è poi evoluto mediante la rapida espansione che si

osserva oggi. I detrattori di questa descrizione ritenevano che non avesse senso

definire un istante di inizio, e definirono spregiativamente questa ipotesi

ipotesi del Big Bang, ossia del grande scoppio. Dalla Legge di Hubble è inoltre

possibile stimare approssimativamente quanto tempo fa sia avvenuto il Big Bang:

questo tempo viene quindi assunto essere l'età dell'Universo. Purtroppo, data

l'incertezza nei dati sperimentali, tale misura risulta a tutt'oggi imprecisa,

fissando pero’ l'età cosmica intorno ai 14 miliardi di anni. Dato che

la quantità di materia deve rimanere costante, il fenomeno dell'espansione fa

si che la densità aumenti più spingiamo le osservazioni lontano, e quindi

indietro nel tempo. Nel nostro curioso viaggio a ritroso nel tempo possiamo

constatare che l’aumento della densità di materia si traduce anche in un

riscaldamento proporzionale alla riduzione delle dimensioni. In passato

l'Universo è stato quindi molto più caldo di quanto non lo sia oggi, fino a

raggiungere temperature che permettevano il verificarsi di fenomeni fisici che

attualmente non possono più avere luogo. Analizzando quantitativamente le

conseguenze di questo modello, nel 1948 Gamow, Alpher e Hermann, su basi

puramente teoriche, furono in grado di prevedere che se il modello del Big Bang

fosse stato corretto, oggi si dovrebbe osservare una radiazione diffusa in tutto

l'Universo attuale alla temperatura di 5 K (5 gradi Kelvin, ossia 268 gradi

sotto lo zero Celsius). Nella teoria di Gamow la presenza di questa radiazione

era l’"immagine" del Big Bang: osserviamo a una tale distanza, e

quindi talmente indietro nel tempo, che si vede la radiazione liberata nelle

reazioni ad alta energia nell'Universo primordiale!

Scoperta

della radiazione fossile

Nel

1965 due ingegneri americani dei Laboratori Bell, Arno Penzias e Robert Wilson,

collaudando un'antenna per trasmissioni radio con i satelliti ECHO, notarono

un disturbo costante sovrapposto ai segnali; mentre proseguivano inutilmente i

tentativi per eliminarlo, cominciarono a sospettare che tale rumore di fondo

fosse di origine cosmica e non dovuto a difetti dello strumento. L’anno

successivo i cosmologi Dicke e Peebles, che lavoravano a Princeton, a poca

distanza dai Laboratori Bell, si resero conto che l'interpretazione poteva

risiedere nel calcolo di Gamow di pochi anni prima. Iniziarono quindi studi

sistematici che mostrarono immediatamente la correttezza del modello del Big

Bang nel prevedere le caratteristiche di questa radiazione, che venne definita

“radiazione cosmica di fondo” o anche “radiazione fossile”. In questo

modo e in maniera sostanzialmente inattesa, si ebbe una conferma stringente

all'ipotesi del Big Bang. Infatti a tutt'oggi qualunque modello di Universo che

non preveda un'origine calda, come nel caso del Big Bang, non è in realtà in

grado di spiegare la presenza della radiazione fossile. E naturalmente questo

vale anche per i mdelli di universo stazionario, praticamente caduti in disuso

dopo tali scoperte.

Se

da un lato la presenza della radiazione di fondo ha permesso di confermare che

nel passato l'Universo deve essere stato notevolmente più caldo rispetto

all'epoca attuale, dall'altro studi sempre più approfonditi permettono, e

permetteranno in futuro, di avere informazioni più dettagliate riguardanti

l'Universo in questa fase primordiale della sua evoluzione.

Formazione

della Radiazione di Fondo

Come

abbiamo visto, se supponiamo di osservare l’Universo lontano del passato, ci

aspettiamo un incremento nella densità di materia proporzionale alla

diminuzione del raggio dell'Universo. Assumendo di poter trattare il Cosmo come

una nube di gas e di continuare il nostro bizzarro viaggio indietro nel tempo,

la crescita di densità della materia posta a distanze sufficientemente grandi

ci porterà a osservare materia sempre più calda, fino a una temperatura

sufficiente a ionizzare gli atomi; infatti i costituenti dell'Idrogeno, protoni

ed elettroni, si separano quando la temperatura raggiunge i 3500-4000 K. Gli

elettroni liberi interagiscono molto più facilmente con la radiazione rispetto

a quelli legati, a tal punto che la radiazione emessa dalla materia in questo

stato, detto di plasma, non si propaga più in maniera indisturbata ma subisce

fenomeni continui di urto elastico con gli elettroni. La distanza media che

intercorre tra una interazione e la successiva decresce fino a rendere

l'Universo completamente opaco, come accade nella nebbia, realizzando ciò che

tecnicamente viene definito equilibrio materia-radiazione. Questo porta a due

risultati molto importanti: 1) a causa di questa opacità non è possibile

spingere lo sguardo più lontano, o più indietro nel tempo, poiché

l’Universo non è più trasparente (questo processo si dice disaccoppiamento

materia-radiazione); 2) l’Universo viene riempito dalla radiazione liberata

dal plasma nel periodo in cui la temperatura scende sotto i 4000 gradi e lo

spazio diviene trasparente. Alla luce di questa osservazione la radiazione

fossile appare quindi l’osservabile più vecchia dell'Universo. Da quando la

temperatura è

scesa sotto questo valore e protoni ed elettroni hanno formato gli atomi (ricombinazione),

l’Universo si è espanso all’incirca di 1100 volte: questo comporta che la

radiazione, emessa nel visibile (con una lunghezza d’onda di meno di un

micron) viene osservata oggi a lunghezze d’onda dell’ordine del millimetro,

che corrisponde ad una temperatura di circa 3 K, in discreto accordo con la

previsione teorica di Gamow. Infine, studiando a fondo il modello del Big Bang e

prendendo a prestito numerosi risultati dalla fisica delle particelle e dalla

fisica nucleare, si è potuto stabilire che i processi di disaccoppiamento sono

avvenuti quando l'Universo aveva più o meno 300000 anni: osservando la

radiazione fossile noi oggi osserviamo l'Universo quando aveva appunto quell'età.

Lo

spettro della Radiazione di Fondo

Qualunque

radiazione è caratterizzata da uno spettro, ossia dalla intensità irraggiata

ad una frequenza fissata. Il processo fisico che determina lo spettro della

radiazione di fondo è proprio l'emissione di radiazione da parte degli

elettroni, che in generale segue una legge detta del corpo nero. Quando la

radiazione e gli elettroni sono in continua e stretta interazione tra loro come

ci aspettiamo nel plasma dell’Universo primordiale, o come accade nelle

stelle, la radiazione emessa dal sistema ha uno spettro che ricalca la

distribuzione dell’energia degli elettroni stessi: lo spettro assunto da una

radiazione di questo tipo prende il nome di spettro di corpo nero. Una delle

scoperte più importanti nella Cosmologia è stata proprio il fatto che,

studiando lo spettro della radiazione fossile, si è riscontrato uno

strettissimo accordo con lo spettro di corpo nero, il che dimostra che è stata

generata in un periodo in cui materia e radiazione erano in condizioni di

equilibrio, proprio come previsto nella teoria del Big Bang. La conferma

osservativa di questo aspetto è arrivata solo nei primi anni ’90, grazie alle

misure svolte dal gruppo diretto da John Mather, della NASA, uno dei due

vincitori del premio Nobel 2006, a bordo del satellite americano COBE (COsmic

microwave Background

Explorer). Sfruttando una proprietà peculiare del corpo nero è possibile

misurare con estrema precisione la temperatura attuale della radiazione di

fondo. Vi è una legge (legge di Wien) che stabilisce che il prodotto tra

temperatura di un corpo nero e la lunghezza d'onda alla quale si osserva la

massima emissione assume sempre lo stesso valore, indipendentemente dal sistema

in esame. E' quindi possibile ricavare la temperatura dalla forma spettrale:

questo metodo viene usato abitualmente per misurare la temperatura delle stelle,

o anche in metallurgia per conoscere quella del metallo fuso. L'applicazione

della legge di Wien allo spettro della radiazione di fondo fornisce una

temperatura di 2.76 K con un errore limitato a qualche parte su mille: la cosa

stupefacente delle misure di COBE è l’accordo tra la curva teorica per il

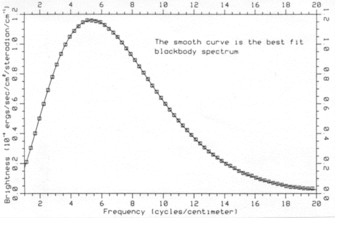

corpo nero e i dati osservativi (Fig. 1).

Fig.

1. Spettro della radiazione cosmica di fondo osservato da COBE. I punti

sperimentali si situano molto bene sulla curva teorica di corpo nero come

spiegato nel testo. Per gentile cortesia di M. Allen.

Lo

spettro della radiazione fossile risulta infatti essere il miglior spettro di

corpo nero mai osservato in natura, il che dimostra che la radiazione si è

propagata assolutamente indisturbata dal momento del disaccoppiamento fino ad

oggi. Questo permette di tentare una strada per ricavare informazioni

sull’evoluzione dell'Universo prima del disaccoppiamento. Infatti la ricerca

di piccole deviazioni dallo spettro ideale del corpo nero permette in linea di

principio di evidenziare e caratterizzare eventuali fenomeni che abbiano

perturbato localmente l'equilibrio termico.

Fluttazioni

di temperatura

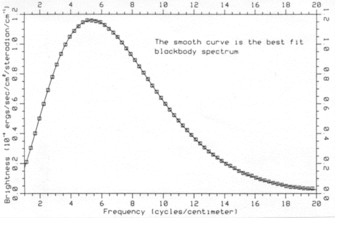

L’altro aspetto importante nello studio della radiazione di fondo si incontra quando si misura la temperatura in diverse regioni del cielo: fino agli anni 90’ non era mai stata osservata una regione del cielo con una temperatura diversa dalle altre. Chi ha dato all’Universo una tale uniformità? Inoltre oggi la distribuzione della materia non è per niente uniforme, ma è strutturata in regioni che si pensa siano derivate da fluttuazioni di densità della materia primordiale: come mai la radiazione di fondo è così isotropa? Cercando di rispondere a queste domande ci imbattiamo subito nell’argomento del secondo premio Nobel di quest’anno, assegnato a George Smoot, di Berkeley. Responsabile di un altro strumento a bordo di COBE, nel 1992 Smoot e la sua equipe hanno dimostrato che la radiazione di fondo presenta effettivamente fluttuazioni di temperatura.

Fig. 2. Mappa del cielo vista da COBE, con i diversi colori che corrispondono a diverse temperature, come spiegato nel testo. Le differenze di temperatura sono solamente di una parte su centomila (l’equatore della mappa coincide con il piano della nostra Galassia). Tratto da www.wikipedia.org.

La

Fig. 2 mostra l’ormai famosa “mappa del cielo” di COBE, una mappa delle

temperature del cosmo osservabile in cui i diversi colori rappresentano diverse

temperature. E’ da evidenziare che le differenze di temperature nella figura

sono pero’ solamente al livello di una parte su centomila. Quindi differenze

piccolissime, ma estremamente importanti, per il fatto che le fluttuazioni di

temperatura sono proprio legate alle fluttuazioni di densità della materia

primordiale: regioni più ricche di materia appaiono oggi più fredde nella

radiazione di fondo, mentre regioni meno ricche appaiono più calde. In altri

termini il gruppo di Smoot ha quindi osservato per la prima volta, seppur

indirettamente, l’aspetto della distribuzione di materia al disaccoppiamento.

Dicembre 2006

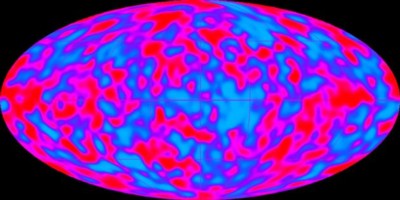

Dal CERN di Ginevra al Gran Sasso: 730 km in 3 millisecondi!

Lo scorso Agosto un fascio di neutrini muonici creato

negli acceleratori di particelle del CERN (Centro Europeo per la Ricerca

Nucleare) di Ginevra è stato “sparato” verso i laboratori sotterranei del

Gran Sasso situati a 730 km di distanza. In questo progetto, denominato CNGS (CERN

Neutrino to Gran Sasso), qualche migliaio di miliardi di neutrini ha percorso il

tragitto in meno di 3 millesimi di secondo. Di questi neutrini, i ricercatori

sperano di rilevarne alcuni, e specialmente quelli che durante il viaggio hanno

cambiato le proprie caratteristiche trasformandosi in neutrini di tipo “tauonico”.

Nonostante l’enorme numero di neutrini che giungono al Laboratorio sotterraneo

del Gran Sasso, soltanto una piccola manciata di questi da un segnale negli

apparati sperimentali; ciò è dovuto alla piccolissima probabilità (in gergo

scientifico si parla di sezione d’urto) che queste particelle hanno di

interagire con la materia. Per questo motivo sono necessari apparati

sperimentali di massa imponente, pesanti diverse migliaia di tonnellate.

La carta d’identità dei neutrini

L’attuale modello che spiega di cosa la materia è costituita e come

questa interagisce è il cosiddetto “Modello Standard”. Nell’ambito di

questo modello, il mondo che ci circonda è costituito da tre famiglie di

leptoni e da altrettante famiglie di quarks. Queste particelle interagiscono

scambiandosi “quanti” di interazioni come il fotone, i bosoni vettori

intermedi ed i gluoni. Non è pero’ questa la sede giusta per approfondire

queste tematiche in modo molto più rigoroso. Per i lettori che intendono

proseguire lungo questa ardua ma affascinante strada suggeriamo come possibile

punto di partenza il bellissimo

sito internet http://www.infn.it/multimedia/particle/paitaliano/adventure_home.html).

I leptoni si distinguono in leptoni carichi e leptoni neutri: il più leggero

dei leptoni carichi è l’elettrone, seguono un suo “fratello maggiore” il

muone, circa 200 volte più massivo, ed un terzo ancora più pesante, il tauone,

con una massa di dirca 3500 volte quella dell’elettrone. Ad ognuno di questi

leptoni è associato un neutrino e precisamente un neutrino elettronico per

l’elettrone, un neutrino muonico (o neutrino mu) per il muone ed un neutrino

tauonico (o neutrino tau) per il leptone tau. Nell’ambito del

Modello Standard i neutrini sono privi di massa, ma recenti esperimenti hanno

dimostrato che i neutrini devono invece avere una massa, sebbene piccolissima.

Tale evidenza si è manifestata attraverso un fenomeno detto di oscillazione

attraverso il quale neutrini di un dato “sapore”, ad esempio di tipo

elettronico, cambiano la loro natura, in neutrini di tipo muonico o tauonico,

durante il loro propagarsi dal punto di creazione al punto di rivelazione.

Affinché ciò avvenga occorre appunto che la differenza di massa tra i diversi

tipi di neutrino sia diversa da zero, e ciò comporta che i neutrini stessi

siano dotati di massa. Malgrado lo studio del fenomeno dell’oscillazione non

permetta di fissare un valore assoluto di massa a queste particelle (essendo

sensibile solo a differenze tra masse), esso è in grado di fornire dei limiti a

tale valore; oggi possiamo affermare che la massa del neutrino elettronico è

almeno 250000 più piccola dei quella dell’elettrone. Ma soprattutto possiamo

affermare che la massa di almeno un paio di neutrini è diversa da zero. I

neutrini sono prodotti in molti processi fisici e sono presenti nell’universo

in numero di qualche centinaio per centimetro cubo, valore da confrontare a

qualche protone per metro cubo presente nello spazio cosmico del nostro

universo. I neutrini sono prodotti nei processi di interazione debole come il

decadimento beta nel quale un nucleo si trasforma in un altro nucleo emettendo

un elettrone (o positrone) e un antineutrino (o neutrino). Particolarmente

copiosi sono i neutrini provenienti dal sole; qualcosa come 60 miliardi di

neutrini elettronici per centimetro quadrato giungono sulla terra ogni secondo.

Malgrado questo enorme flusso, soltanto una piccolissima di essi frazione

interagirà con il nostro pianeta; ciò è dovuto alla piccola sezione d’urto

cui si accennava precedentemente. Ciò che i fisici si prefiggono di studiare, sono le proprietà di questa

effimera e strana particella. Per fare ciò, oltre alla rivelazione di neutrini

“naturali” come quelli solari o i neutrini atmosferici (quelli prodotti

dall’interazione dei raggi cosmici con l’atmosfera) gli scienziati si sono

serviti degli antineutrini prodotti dai decadimenti dei prodotti di fissione

delle centrali nucleari e anche (è di questi che parleremo nel seguito) di

neutrini muonici prodotti con l’ausilio di acceleratori di particelle.

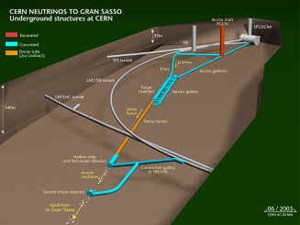

La creazione

I neutrini muonici sono stati prodotti utilizzando il collisionatore Super

Proton Synchrotron (SPS) del CERN vicino a Ginevra (fig. 1). L’SPS è in grado

di accelerare protoni fino a 400 GeV. Il GeV è una unità di energia pari circa

all’equivalente della massa del protone (che, per essere precisi, è di 0.938

GeV). Quindi un protone da 400 GeV ha una energia totale di oltre 400 superiore

alla sua massa a riposo. Trovandosi quindi in un regime completamente

relativistico, si muove praticamente alla velocità della luce.

Ogni tre secondi i protoni del fascio dell’SPS vengono fatti interagire;

circa 24000 miliardi di questi protoni vengono inviati contro un bersaglio di

grafite composto da 13 cilindri di qualche millimetro di diametro.

L’interazione dei protoni di così alta energia con i nuclei del materiale

produce un fascio di pioni (p)

e di kaoni (K). Il fascio viene poi focalizzato grazie a un sistema di magneti

ed indirizzato verso i laboratori sotterranei del Gran Sasso. Anche queste nuove

particelle cosi’ prodotte sono del tutto relativistiche.I mesoni p

e K percorrendo un tunnel di circa 1 km di lunghezza decadono generando muoni e

neutrini i quali continueranno a viaggiare con la stessa direzione dei mesoni

che li hanno generati. In questo modo si ottiene un fascio composto al 95% di

neutrini muonici con una energia media di 17.4 GeV. Il restante 5% è costituito

da antineutrini muoni nella misura del 4% e il rimanete 1% da neutrini ed

antineutrini di tipo elettronico.

Il fascio di neutrini inizia quindi il sua viaggio sotterraneo attraversando

mezza Italia (fig. 2) praticamente indisturbato; al suo arrivo in Abruzzo si

presenta con una superficie di

circa un chilometro quadrato.

La

rivelazione

Ad attendere i neutrini, al riparo dalla radiazione cosmica sotto 1400 metri di roccia, nelle grandi sale sperimentali del Laboratorio Nazionale del Gran Sasso (LNGS) ci sono diversi apparati sperimentali, alcuni grandi quanto palazzine di 3 piani. Questi laboratori videro la luce 25 anni fa, e furono costruiti con le tre grandi sale sperimentali denominate A B e C (ognuna con altezza di un centinaio di metri, larghezza e altezza di circa venti metri) direzionate verso il CERN proprio per accogliere i neutrini “sparati” da Ginevra. Uno di questi apparati, OPERA (Oscillation Project whit Emulsion tRacking Apparatus, fig. 3), con una massa totale di circa 1800 tonnellate, è installato nella sala C, ed è stato realizzato da una collaborazione internazionale con lo scopo di rivelare i neutrini tau dal fascio originario costituito, come abbiamo detto, quasi esclusivamente da neutrini muonici. Essendo i neutrini privi di carica elettrica, possono essere rivelati solo attraverso le tracce prodotte dalla loro interazione con i nuclei costituenti il rivelatore. Il neutrino tau produce oltre ad altre particelle il leptone tau o tauone il quale decade prontamente in 3x10-13 secondi percorrendo meno di 1 mm e generando altre particelle come ad esempio muoni e neutrini o adroni e neutrini. La caratteristica che permette di riconoscere un evento nucleare prodotto da un neutrino tau è quello di contenere una traccia con una deviazione a gomito nel punto del decadimento (fig. 4). L’apparato sperimentale è costituito da due grandi moduli in cui la parte sensibile è costituita da 12 milioni di emulsioni nucleari assemblate con altrettanti strati sottili di piombo formando 200000 “mattoni” all’interno dei quali interagisce il neutrino. Oltre alle emulsioni nucleari, ci sono dei rivelatori composti da strisce scintillanti che hanno il compito di determinare in tempo reale le coordinate dell’evento di interazione. A completare l’apparato troviamo un forte campo magnetico e dei rivelatori di tracciamento per la misura dell’energia del muone prodotto dal decadimento del neutrino tau. Malgrado l’enorme massa, OPERA dovrebbe rivelare solo poche decine di eventi da neutrino tau nei prossimi anni. Oltre ad OPERA altri esperimenti sono in grado di fornire utili informazioni sul funzionamento e sul valore dei parametri di oscillazioni; tra questi ICARUS costituito da 600 tonnelate di argon liquido in grado di ricostruire immagini tridimensionali degli eventi, Borexino costituito da 300 tonnellate di scintillatore liquido il cui scopo principale è la rivelazione e lo studio dei neutrini solari, e LVD concepito per la rivelazione di neutrini emessi durante l’esplosione di una supernova.

Fig. 1. La generazione del fascio di neutrini al CERN si svolge nel

complesso degli acceleratori installato a Ginevra, vicino al confine tra Francia

e Svizzera.

Fig. 1. La generazione del fascio di neutrini al CERN si svolge nel

complesso degli acceleratori installato a Ginevra, vicino al confine tra Francia

e Svizzera.

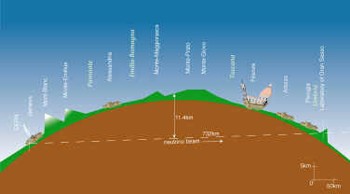

Figura

2. Nel loro percorso i neutrini passano alla profondità di alcuni chilometri

prima di tornare in superficie al Gran Sasso..

Fig. 3. Fisici, ingegneri e tecnici installano il rivelatore Opera, al Gran

Sasso.

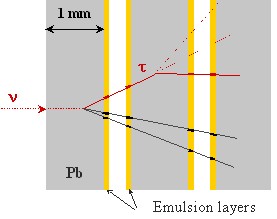

Fig. 4. Il neutrino tau interagisce nel piombo di OPERA dando luogo ad un

mesone tau che viene identificato dalla sua breve vita e dalla presenza di un

muone tra le particelle prodotte.

Settembre 2006

Lino Miramonti e Marco

G. Giammarchi

Da fantascienza a scienza applicata: storia e gloria dei Neutrini

Il neutrino, particella fantasma della fisica atomica e nucleare ha ormai

oltre ottanta anni di storia. In un mirabolante percorso, dalla ipotesi alla

scoperta e infine al suo possibile sfruttamento nel futuro, la storia di questa

elusiva particella rappresenta un affascinante paradigma dello sviluppo e delle

prospettive della scienza moderna.

L’ipotesi

di Pauli

Questa storia inizia all’incirca negli anni ’20, quando i risultati di

osservazioni su alcuni decadimenti di nuclei instabili (decadimenti beta)

sembravano indicare una apparente violazione di principi fondamentali della

fisica, come la conservazione dell’energia.

La scoperta

Nel 1953 due ricercatori americani, Fred Reines e Clyde Cowan, iniziarono la

costruzione di un rivelatore nelle vicinanze di un reattore nucleare in South

Carolina. Un reattore nucleare di media potenza emette un flusso dell'ordine di

centomila miliardi di neutrini al centimetro quadrato per secondo alla distanza

di 10 metri dal suo nocciolo. Il rivelatore venne installato sottoterra ad una

profondità di 12 metri in modo da proteggere l'apparato dalla radiazione cosmica che

altrimenti avrebbe generato falsi segnali e reso molto difficile

l’identificazione del segnale ricercato.

Neutrini

che vengono dal Cosmo

Le reazioni termonucleari che fanno “vivere” le stelle producono un

enorme numero di neutrini; la quantità di neutrini emessi da una stella è

circa 100 volte maggiore di tutta la radiazione elettromagnetica che essa emette

sotto forma di luce visibile,

infrarossa, ultravioletta, raggi X ecc... Quando poi le stelle più massive

esplodono diventando supernovae, liberano una quantità enorme di energia pari a

quella che il Sole emette durante tutta la sua vita

e anche una enorme quantità di neutrini. L'osservazione di queste particelle

fornisce una preziosa informazione sui processi nucleari stellari, in quanto i neutrini

prodotti giungono a noi praticamente senza essere influenzati dalla materia

interstellare. Inoltre come nel caso della nostra stella ci permettono di

“vederne” direttamente il cuore, un po’ come avviene con i raggi X, grazie

ai quali è possibile visualizzare gli organi interni del corpo umano.

Neutrini

che vengono dal Sole

Per convalidare l’esattezza dei modelli solari apparsi nella prima metà

degli anni ’60 due fisici statunitensi, Raymond Davis e John Bahcall,

proposero la costruzione di un rivelatore di neutrini; nel 1964 in una miniera

d’oro a Homestake (South Dakota), venne realizzata una grande piscina di 600

tonnellate di tetracloruroetile dove alcuni

atomi al giorno si sarebbero dovuti trasformare in seguito

all’interazione di neutrini provenienti dal Sole. Il numero di neutrini

rivelati, risultò però inferiore a quello previsto dai modelli solari. Oggi

sappiamo che tale deficit va ricercato tra le proprietà stesse del neutrino.

Neutrini

che vengono dal centro della Terra

Un nuovo rivelatore sotterraneo giapponese e’ entrato da poco in funzione

nel complesso minerario di Kamioda; si tratta di KamLAND, che ha verificato il

fenomeno delle oscillazioni stavolta sfruttando neutrini emessi dalle vicine

centrali nucleari giapponesi e coreane. Oltre agli eventi generati dai neutrini

di fissione nei reattori la collaborazione KamLAND ha osservato per la prima

volta neutrini (o, per essere piu’ precisi, anti-neutrini) da una sorgente che

forse il lettore non si aspetta: il nostro stesso pianeta.

Conclusione

Previsto nel 1930 e scoperto nel ’56, il neutrino si è rivelato un

prezioso strumento di indagine in fisica delle particelle, nello studio delle

interazioni fondamentali e di corpi celesti come il Sole. Dopo averne

determinato proprieta’ come il

sapore e l’oscillazione, fisici e geologi si apprestano ora ad utilizzarlo per

lo studio dell’interno della Terra.

Giugno

2006

Marco G. Giammarchi e Lino Miramonti

Fig.

1. Foto del rivelatore SNO durante la sua costruzione. Una gigantesta sfera

ricoperta da fotomoltiplicatori (sensori di luce) viene usata per contenere

l’acqua pesante su cui i neutrini interagiscono. L’inserto in basso a destra

illustra la struttura generale del rivelatore, installato in una miniera di

nichel in Ontario.

Fig.

1. Foto del rivelatore SNO durante la sua costruzione. Una gigantesta sfera

ricoperta da fotomoltiplicatori (sensori di luce) viene usata per contenere

l’acqua pesante su cui i neutrini interagiscono. L’inserto in basso a destra

illustra la struttura generale del rivelatore, installato in una miniera di

nichel in Ontario.

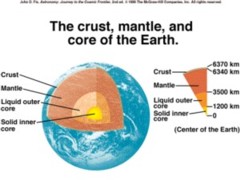

Figura

2. L’interno della Terra viene di solito schematizzato mediante una serie di

strati. Il contenuto di materiale radioattivo varia da strato a strato.

Figura

2. L’interno della Terra viene di solito schematizzato mediante una serie di

strati. Il contenuto di materiale radioattivo varia da strato a strato.

Fig.

3. Fisici, ingegneri e tecnici installano il rivelatore Borexino, al Gran Sasso.

Un contenitore flessibile di nylon viene sospeso al centro di una sfera di

acciaio del diametro di quasi 14 metri e ricoperta da 2200 sensori di luce.

Fig.

3. Fisici, ingegneri e tecnici installano il rivelatore Borexino, al Gran Sasso.

Un contenitore flessibile di nylon viene sospeso al centro di una sfera di

acciaio del diametro di quasi 14 metri e ricoperta da 2200 sensori di luce.

-------------------------------------------------------------------------------------------------------------------------

ITER: la via verso la fusione termonucleare controllata di Simone Coelli e Marco G. Giammarchi

“ITER”

- acronimo di “International Thermonuclear Experimental Reactor” - è una

parola latina che significa percorso e sottolinea l’obiettivo di un grande

progetto scientifico su scala mondiale, la dimostrazione di fattibilità della

fusione termonucleare controllata.  Con

ITER si vuole realizzare di un impianto prototipo in grado di generare e

sostenere stabilmente reazioni di fusione di un plasma di Deuterio e Trizio

confinato magneticamente in un reattore di tipo Tokamak. Vediamo con calma di

cosa si tratta. Iniziamo col

distinguere il processo di fusione nucleare dal quello che consente il

funzionamento delle odierne centrali “a fissione”. Mentre nella fissione

nuclei pesanti (Uranio, Plutonio…) vengono suddivisi in nuclei più piccoli,

nella fusione nuclei leggeri (Trizio, Deuterio…) vengono fatti unire per

formare un nucleo più grande; in entrambe i casi si guadagna energia. I moderni

impianti a fissione hanno un elevato livello di sicurezza ma lo svantaggio

principale di questa tecnologia è la generazione dei frammenti di fissione e

degli elementi transuranici. Questi sono nuclei instabili (radioattivi), la

dispersione dei quali determina il fattore principale di rischio in un incidente

al reattore o al combustibile estratto a fine vita, le famose “scorie

nucleari”, che purtroppo hanno tempi di dimezzamento estremamente lunghi. Nel

processo della “fusione” si libera energia dall’unione di nuclei leggeri

che fondono in un nucleo più pesante e stabile. Occorre operare in particolari

condizioni perchè avvenga questo tipo di reazione; infatti i nuclei per

fondersi devono essere fatti avvicinare contrastando la forte repulsione

elettrica che subiscono essendo entrambi dotati di carica positiva. Riferendoci

in particolare alla tecnologia di ITER ci limiteremo solo alla fusione

termonucleare a confinamento magnetico, nella quale le elevate energie cinetiche

delle particelle portate nella condizione di plasma termonucleare (gas

completamente ionizzato a temperature di molti milioni di gradi) rendono

possibile lo scontro dei nuclei e la loro fusione. In un reattore di questo tipo (Tokamak) si

sfrutta il fatto che le particelle sono dotate di carica elettrica per ottenere

il confinamento del plasma mediante complessi campi magnetici in una camera

toroidale, all’interno della quale si crea una sorta di ciambella di plasma. I

reagenti, cioè i nuclei introdotti nel reattore per sostenere le reazioni di

fusione, sono gli isotopi dell’idrogeno, Deuterio e Trizio. Questi isotopi

hanno sempre una carica positiva unitaria nel nucleo costituita da un protone,

ma hanno rispettivamente anche uno o due neutroni nei loro nuclei. La reazione -

indicata come D+T - è quella che riveste il maggiore interesse, perchè

minimizza le repulsione tra i nuclei e rende massima la probabilità che si

inneschino le reazioni di fusione; la temperatura di accensione per questo

plasma è di circa 50 milioni di gradi, piu’ alta di quella del centro del

Sole. I prodotti della reazione D+T sono un nucleo di elio e un neutrone

energetico.A prima vista questo sembrerebbe un processo più pulito e sicuro

della fissione data l’assenza di combustibile esausto altamente radioattivo e

la mancanza del pericolo di criticità incontrollata (un malfunzionamento

accidentale del sistema provocherebbe l’esaurimento immediato del processo).

Tuttavia la manipolazione di un isotopo radioattivo come il Trizio e la

produzione di molti altri radioisotopi per attivazione dei materiali da parte

dell’intenso flusso di neutroni, rendono comunque un reattore a fusione degno

delle stesse attenzioni necessarie nelle altre tecnologie nucleari.

Con

ITER si vuole realizzare di un impianto prototipo in grado di generare e

sostenere stabilmente reazioni di fusione di un plasma di Deuterio e Trizio

confinato magneticamente in un reattore di tipo Tokamak. Vediamo con calma di

cosa si tratta. Iniziamo col

distinguere il processo di fusione nucleare dal quello che consente il

funzionamento delle odierne centrali “a fissione”. Mentre nella fissione

nuclei pesanti (Uranio, Plutonio…) vengono suddivisi in nuclei più piccoli,

nella fusione nuclei leggeri (Trizio, Deuterio…) vengono fatti unire per

formare un nucleo più grande; in entrambe i casi si guadagna energia. I moderni

impianti a fissione hanno un elevato livello di sicurezza ma lo svantaggio

principale di questa tecnologia è la generazione dei frammenti di fissione e

degli elementi transuranici. Questi sono nuclei instabili (radioattivi), la

dispersione dei quali determina il fattore principale di rischio in un incidente

al reattore o al combustibile estratto a fine vita, le famose “scorie

nucleari”, che purtroppo hanno tempi di dimezzamento estremamente lunghi. Nel

processo della “fusione” si libera energia dall’unione di nuclei leggeri

che fondono in un nucleo più pesante e stabile. Occorre operare in particolari

condizioni perchè avvenga questo tipo di reazione; infatti i nuclei per

fondersi devono essere fatti avvicinare contrastando la forte repulsione

elettrica che subiscono essendo entrambi dotati di carica positiva. Riferendoci

in particolare alla tecnologia di ITER ci limiteremo solo alla fusione

termonucleare a confinamento magnetico, nella quale le elevate energie cinetiche

delle particelle portate nella condizione di plasma termonucleare (gas

completamente ionizzato a temperature di molti milioni di gradi) rendono

possibile lo scontro dei nuclei e la loro fusione. In un reattore di questo tipo (Tokamak) si

sfrutta il fatto che le particelle sono dotate di carica elettrica per ottenere

il confinamento del plasma mediante complessi campi magnetici in una camera

toroidale, all’interno della quale si crea una sorta di ciambella di plasma. I

reagenti, cioè i nuclei introdotti nel reattore per sostenere le reazioni di

fusione, sono gli isotopi dell’idrogeno, Deuterio e Trizio. Questi isotopi

hanno sempre una carica positiva unitaria nel nucleo costituita da un protone,

ma hanno rispettivamente anche uno o due neutroni nei loro nuclei. La reazione -

indicata come D+T - è quella che riveste il maggiore interesse, perchè

minimizza le repulsione tra i nuclei e rende massima la probabilità che si

inneschino le reazioni di fusione; la temperatura di accensione per questo

plasma è di circa 50 milioni di gradi, piu’ alta di quella del centro del

Sole. I prodotti della reazione D+T sono un nucleo di elio e un neutrone

energetico.A prima vista questo sembrerebbe un processo più pulito e sicuro

della fissione data l’assenza di combustibile esausto altamente radioattivo e

la mancanza del pericolo di criticità incontrollata (un malfunzionamento

accidentale del sistema provocherebbe l’esaurimento immediato del processo).

Tuttavia la manipolazione di un isotopo radioattivo come il Trizio e la

produzione di molti altri radioisotopi per attivazione dei materiali da parte

dell’intenso flusso di neutroni, rendono comunque un reattore a fusione degno

delle stesse attenzioni necessarie nelle altre tecnologie nucleari.

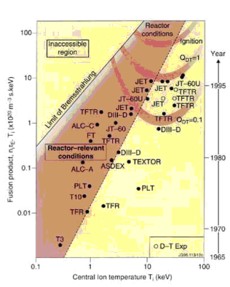

Lo scopo di ITER

Il principio di funzionamento delle stelle,

come il nostro Sole, si basa sulle reazioni di fusione, che sono quindi

diffusissime nell’Universo. La ricerca orientata alla riproduzione di questo

processo sulla Terra può essere in qualche modo riassunta per mezzo del

“diagramma di Lawson” che illustra graficamente il criterio legato alle

condizioni minime necessarie affinchè un plasma termonucleare raggiunga una

condizione di funzionamento dove si abbia una produzione netta di energia. Per

guadagnare energia è necessario raggiungere una certa zona dei parametri nel

diagramma di Lawson (fig. 1). Senza scendere nei dettagli questo significa che

il plasma deve essere confinato per tempi abbastanza lunghi in condizioni di

densità e temperatura sufficienti a sostenere il processo di fusione in modo

continuo e produttivo. La storia di questa ricerca è quindi quella di una lunga

“arrampicata” nel diagramma di Lawson, fino alla regione interessante dei

parametri, quella in alto a destra nella figura 1. ITER giungerà più in alto

nel grafico rispetto a tutti i precedenti reattori sperimentali (come JET o TFTR),

fino ad un punto in cui si potrà

dimostrare se effettivamente il sogno di sfruttare tale fonte di energia sarà

realizzabile.

Fig. 1. Diagramma di Lawson. Sull’asse orizzontale la temperatura del plasma e

sull’altro un indicatore della bontà del confinamento (il prodotto della

densità del plasma per il tempo di confinamento). ITER raggiungera’ zone in

cui Q > 1, dove il reattore produce più energia di quella che consuma.

Nascita del progetto ITER

La ricerca sulla fusione – fenomeno

fisico scoperto nel 1936, prima della fissione -

ha una lunga tradizione in tutto il mondo, dalla Russia al Giappone

all’Europa e agli Stati Uniti. Approcci diversi sono stati seguiti dai diversi

paesi e alcuni - come la fusione inerziale

- vengono ancora perseguiti (anche per scopi militari). Tuttavia è

emersa chiaramente alla fine dell’ultimo secolo la consapevolezza che nessuna

nazione o contesto continentale avrebbe avuto le risorse per affrontare il

prossimo decisivo passo: la costruzione di un reattore termonucleare

dimostrativo a guadagno superiore a uno. Nasce il progetto ITER per un reattore

mondiale sulla fusione. La discussione su dove costruire il mega-reattore è

stata lunga e difficile e alla fine ha visto due schieramenti dividersi sulla

possibilità di costruirlo in Europa (idea sostenuta da Russia, Unione Europea e

Cina) o in Giappone (come preferito da Corea del Sud, Stati Uniti e Giappone).

Alla fine, anche come soluzione di compromesso, si è deciso per il sito

europeo, ma con l’accordo che il reattore avrà uno staff dirigenziale

giapponese. Il 28 giugno 2005 è stata quindi ratificata la decisione di

costruire ITER nel sito di Cadarache in Francia, vicino ad Aix-en-Provence.

L’impresa verrà realizzata con le competenze di scienziati e tecnici di tutto

il mondo e con il sostegno economico di Unione Europea, Cina, Giappone, Russia,

Sud Corea, Stati Uniti e Svizzera. Questa stretta cooperazione a livello

mondiale è indispensabile per affrontare l’enorme impegno economico e

tecnologico richiesto da un’impresa così ambiziosa. Tecnicamente ITER

rappresenta il maggiore passo sperimentale tra ricerca e scala industriale nel

programma scientifico di sfruttamento dell’energia nucleare da fusione a scopo

pacifico. L’energia dei prodotti di reazione potrebbe essere convertita in

energia elettrica, anche se la generazione di potenza elettrica non è

l’obiettivo di ITER che consiste invece nella dimostrazione della fattibilità

scientifica. Solo dopo aver raggiunto questo traguardo sarà possibile pensare

alla costruzione di centrali di potenza e si dovrà allora investigare se sarà

possibile rendere la fusione anche economicamente competitiva rispetto alle

altre fonti energetiche. Questo dipenderà inevitabilmente dalle strategie

energetiche che i paesi intenderanno

attuare. Naturalmente, come per qualunque altra fonte energetica, nel computo

della competitività si dovranno tenere in conto tutti i costi inerenti al

trattamento in sicurezza dei materiali radioattivi, inquinanti o comunque

socialmente pericolosi coinvolti nel ciclo di produzione.Nel contesto energetico

mondiale il crescente aumento della domanda dovrà essere fronteggiato nel

prossimo futuro sfruttando oltre alle risorse fossili (petrolio, gas, carbone,

in inesorabile diminuzione), una crescente percentuale di energie rinnovabili

(idrica, eolica, solare, biomasse) e, nonostante l’attuale rallentamento dei

relativi programmi, la fissione nucleare. In questo scenario la fusione nucleare

rappresenterà forse una possibile alternativa e merita oggi di essere studiata,

anche in vista dell’indotto tecnologico e delle relative ricadute

scientifiche, ma senza crearsi eccessive illusioni.

Come funziona il reattore ITER?

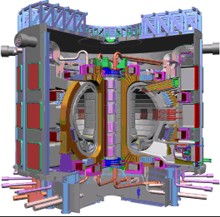

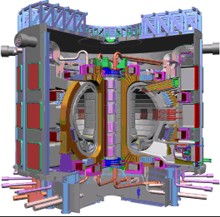

ITER sarà la più grande macchina di

questo tipo mai costruita, in grado di produrre 500 Megawatt di potenza in

condizioni di autosostentamento della reazione. I suoi parametri di progetto

sono tali da permettere di ottimizzare il processo durante le fasi di

sperimentazione grazie a flessibilità di potenza di fusione, densità e fattori

di forma del plasma, comando delle correnti, dei sistemi di alimentazione del

combustibile e sistemi per la sostituzione dei componenti interni del

reattore.Il design di ITER è basato sull’idea di poter collaudare le

tecnologie oggi conosciute per il riscaldamento del plasma, includendo tutte le

possibili tecniche diagnostiche del plasma e lasciando spazio ad eventuali

innovazioni che potranno nascere nel prossimo futuro, durante la sua

realizzazione e utilizzo. Come sistemi principali di riscaldamento del plasma si

sfruttano onde elettromagnetiche e fasci di particelle accelerate che portano la

temperatura nel cuore del plasma oltre i 100 milioni di gradi innescando le

reazioni di fusione termonucleare. Per confinare il plasma, mantenendolo

separato dalle pareti interne della camera anulare del Tokamak (che altrimenti

finirebbero distrutte), si utilizzano complessi campi magnetici creati da bobine

superconduttrici, immerse in criostati ad elio liquido a temperature di pochi

gradi Kelvin, ossia vicinissime allo zero assoluto. L’intensità del campo e

il volume della macchina lo rendono

anche uno dei più grandi magneti del mondo, composto da un sistema magnetico

toroidale (18 bobine alte 12 metri e larghe 8), sei bobine poloidali circolari

(diametri da 6 a 25 m) esterne alla camera toroidale (destinate al controllo di

posizione e forma del plasma), e da un solenoide centrale (del diametro di 3 m e

alto 14 metri) per il riscaldamento del plasma. La durata prevista per le

scariche di plasma è di 400 secondi, ritenuta sufficiente per una dimostrazione

tecnico-scientifica convincente, mentre la corrente circolante nel plasma

raggiunge i 15 milioni di Ampère. La potenza di riscaldamento iniettata è 50

MW mentre le reazioni di fusione dovranno produrre 500 MW, con un incremento di

un fattore Q = 10, rapporto tra quella estratta e quella immessa nel sistema.

Un’amplificazione interessante di energia, per la prima volta ottenibile dopo

le positive esperienze con precedenti reattori, in particolare il JET, che

pero’ poteva al massimo raggiungere solo il pareggio energetico.La potenza

generata viene raccolta nelle pareti interne del Tokamak da apposite strutture

in grado di trasferirla poi al fluido termovettore (acqua) che convoglia il

calore a sistemi di raffreddamento esterni e che in futuro potranno essere dei

turbogeneratori (in grado di convertire la potenza termica in elettrica e infine

immetterla nella rete di distribuzione). Dopo il completamento del reattore

(previsto per il 2016), il periodo di funzionamento previsto è di circa 20 anni

con una miscela di Deuterio e Trizio (D+T) come combustibile. Anche se la

fusione risulta più pulita della fissione, le parti affacciate al plasma

soggette al flusso di neutroni prodotti nelle reazioni di fusione si attivano

durante gli esperimenti. Grande attenzione va posta quindi nella gestione dei

prodotti e delle parti radioattive,

limitandone volumi e tossicità mediante una corretta gestione del ciclo di

smaltimento.

Fig. 2. Spaccato artistico del reattore Tokamak ITER. Le dimensioni di una persona sono rappresentate dell’omino blu in basso.

Conclusione

ITER rappresenta un passo in avanti

decisivo per la fusione termonucleare controllata a scopi pacifici. La

concentrazione di uno sforzo economico e scientifico su scala mondiale permetterà

per la prima volta di guadagnare energia da un prototipo di reattore a fusione.

La costruzione di ITER in Francia è anche una grande occasione per l’Europa e

per l’Italia, sia dal punto di vista strettamente scientifico che da quello

tecnologico e dell’indotto. Realtà come l’ente francese CEA (Commissariat

à l’Energie Atomique) o l’italiana Ansaldo Superconduttori avranno modo di

impiegare e perfezionare la tecnologia necessaria con ricadute positive ad ampio

raggio.Con in mente il bagliore inquietante dei test nucleari delle bombe a

fusione – bomba H – nei quali ci si rende conto delle immense riserve di

energia celate nei nuclei, vorremmo concludere questo articolo con una nota di

ottimismo sulle possibili ricadute pacifiche della ricerca e dell’ingegneria

della fusione nucleare.

20 dicembre 2005

Simone

Coelli e Marco G. Giammarchi

Bibliografia

1) Il sito internet di riferimento, ricco di informazioni e collegamenti è www.iter.org

Una nuova rivoluzione

copernicana: la scoperta dei pianeti extrasolari

Siamo

ormai abituati alle continue scoperte astronomiche, antiche e recenti, e spesso

finiamo col trattarle

con una punta di indifferenza: relegate in qualche breve trafiletto di

quotidiano, non attirano più di tanto la nostra attenzione. Forse nessuna

notizia di carattere astronomico o spaziale ha mai più suscitato lo stesso

interesse generato nell’opinione pubblica dallo sbarco di un uomo sulla Luna,

un evento di ormai 36 anni fa.Tutto questo nonostante le mirabolanti scoperte

sull’origine dell’universo e la sua struttura, le esplorazioni con sonde

automatiche dei pianeti giganti, la Stazione Spaziale Internazionale e tante

altre ancora. Queste scoperte e conquiste, per quanto importanti, sono

essenzialmente conosciute ed apprezzate soprattutto nell’ambito degli

specialisti, astronomi, astrofisici, ingegneri aerospaziali, astronauti e

cosmologi, o di un ristretto pubblico “educato”, quale ad esempio quello

rappresentato dagli astrofili. Forse solo le tristi notizie delle tragedie

umane degli Shuttle e la tanto attesa scoperta di molecole di acqua su Marte

hanno recentemente risvegliato maggiore interesse in una opinione pubblica che a

volte ha obiettive difficoltà a capire l’importanza di gran parte della

ricerca scientifica, e tende naturalmente a soffermarsi sugli aspetti più

facilmente comprensibili ed emotivamente coinvolgenti come l’astronomia e

l’esplorazione dello spazio.

Eppure una serie di scoperte mirabolanti e molto attese sta avendo luogo

in un settore piuttosto nuovo e per certi versi sorprendente. Un settore che ci

riporta a quanto scritto da svariati scrittori di fantascienza del secolo

scorso. In una sola frase, stiamo scoprendo pianeti attorno ad altre stelle: gli

esopianeti. In fondo, non ci dovrebbe essere nulla di strano. Se il Sole è una stella

come tante, pare logico ritenere che anche le altre stelle abbiano il loro bravo

corteo di pianeti. Tuttavia fino a qualche anno fa non era stato possibile avere

evidenza della loro esistenza. Queste scoperte costituiscono una impresa

astronomica impressionante, permettendoci per la prima volta lo studio di

sistemi stellari diversi dal nostro. La quantità di nuovi dati sulle proprietà

e sull’evoluzione di tali sistemi e’ enorme e fornisce informazioni su come

possa essersi formato anche il nostro Sistema Solare.Peraltro la rivelazione di

pianeti che orbitano attorno ad altre stelle e’ una sfida formidabile dal

punto di vista strumentale, dato che i pianeti non brillano di luce propria e si

trovano in prossimità di stelle che al confronto sono milioni di volte più

luminose. Per fare un confronto, è un po’ come se ci trovassimo a Milano e

dovessimo osservare con un sistema di lenti, specchi e cannocchiali una

nocciolina che si trova a Pechino, molto vicino ad una potente lampada alogena

diretta verso di noi. Gli scienziati hanno quindi elaborato sofisticate tecniche

di osservazione che, pur indirettamente, permettono di superare le difficoltà

connesse con una osservazione tanto ardua.

In questa impresa le tecniche impiegate sono tre:

|

Lo studio delle

oscillazioni della posizione della stella vicina (tecnica Doppler). La

posizione di una stella viene debolmente influenzata dalla massa di un

grosso pianeta che le orbita intorno, e subisce un’oscillazione periodica.

Tale oscillazione è

rilevabile mediante lo studio dell’effetto Doppler sulle

sue sulle righe spettrali.

Questo e’ il metodo attualmente piu’ sensibile per rivelare

esopianeti. | |

|

Lo studio della

luminosità totale della stella nel tempo (tecnica

fotometrica). Quando il pianeta

transita davanti alla stella ne

occulta periodicamente una

piccola parte

della luce. Naturalmente questo richiede che l’orbita del pianeta si

interponga tra la stella e la nostra linea di vista (un po’ come avviene

in una eclisse). | |

|

Infine e’ possibile l’osservazione telescopica diretta. Questa tecnica e’ davvero al limite delle capacità tecnologiche attuali a causa della vicinanza tra stella e pianeta e della forte differenza di luminosità: al momento un solo esopianeta è stato osservato in questo modo. |

In dieci anni di ricerca sono stati scoperti circa 152

esopianeti con la tecnica Doppler (osservati attorno a 131 stelle), 5 con la

tecnica fotometrica e solo uno osservato direttamente. La diversità delle tecniche impiegate e il numero ormai elevato di scoperte

non permette piu’ di dubitare in alcun modo dell’esistenza di esopianeti:

così come e’ avvenuto nel caso del

nostro sistema solare, sistemi planetari si sono formati attorno ad altre

stelle.

Ma quali sono le caratteristiche dei pianeti scoperti?

Per scoprirlo ci riferiamo ad un recente lavoro specialistico di rassegna

(1), che è anche la nostra maggiore fonte di ispirazione per questo lavoro.

Innanzitutto occorre premettere che non e’ ancora

possibile rispondere in modo completo a domande sulle proprietà degli

esopianeti per via del fatto che attualmente sono stati osservati solo quelli

piu’ grandi e piu’ vicini alla stella madre. Questo effetto viene

chiamato “effetto di selezione”, e deriva dalle caratteristiche delle

tecniche utilizzate. Quindi le proprietà degli esopianeti non sono ancora del

tutto chiare; in pratica abbiamo buone informazioni solo sui più grandi, più

facili da scoprire e da caratterizzare. Tuttavia i dati a disposizione, ancorchè

incompleti, evidenziano alcune importanti proprietà:

Masse

Le masse

scoperte per i pianeti extrasolari sono molto grandi: si parla di pianeti di

tipo simile a Giove e anche molto piu’ grandi. Come abbiamo detto questo e’

il risultato dell’effetto di selezione. Tuttavia gli astrofisici, studiando la

distribuzione in massa dei pianeti osservati (i piu’ piccoli hanno una massa

15 volte quella della Terra), sono in grado di concludere che una grande quantità

(la maggioranza?) dei pianeti stessi dovrebbe avere masse più piccole. In

particolare si prevede che circa il 12% delle stelle abbiano pianeti simili alla

Terra e distanti meno di 20 Unità Astronomiche (UA, pari alla distanza

Sole-Terra, ovvero circa 149 milioni di chilometri) dalla stella

madre.

Distanza

dalla stella madre

Tutti gli

esopianeti scoperti hanno distanze dalla stella madre comprese tra 0.03 e 5.5

Unità Astronomiche. Anche in questo caso vi e’ un effetto di selezione.

Specialmente con la tecnica Doppler, che è quella che ha dato i maggiori

risultati finora, è più facile scoprire pianeti vicini alla stella madre

piuttosto che pianeti lontani da essa.

Eccentricità

dell’orbita

In generale

sono stati scoperti pianeti con orbite abbastanza eccentriche. Un’orbita e’

detta eccentrica quando e’ sensibilmente allungata in una direzione, mentre è

poco eccentrica quando tende ad avere una forma circolare. L’abbondanza di

orbite eccentriche sembrerebbe indicare che grossi pianeti gassosi con orbite

quasi circolari (quello che avviene nel sistema solare per Giove e Saturno) non

sono poi così comuni come si pensava. Lo studio delle caratteristiche degli esopianeti comprende

naturalmente anche molte altre proprietà fisiche e chimiche. Si sta iniziando a

conoscere la composizione delle atmosfere di alcuni di essi: sodio e idrogeno

sono già stati identificati in esoatmosfere. Inoltre stiamo anche cominciando a

capire la relazione tra la presenza di esopianeti e la composizione chimica (metallicità)

della stella madre; queste osservazioni sono una vera manna per i planetologi

che possono finalmente disporre di altri sistemi “solari” per i loro studi.

Noi non ci addentreremo ulteriormente nella descrizione di queste complesse

ricerche. Rimandiamo invece i lettori interessati alla bibliografia in referenza

1 e al sito web indicato in referenza 2, che viene continuamente aggiornato.

Conclusioni

Oggi non si può più dubitare dell’esistenza dei

pianeti extrasolari; tuttavia la ricerca su di essi e’ ancora fortemente

influenzata da effetti di selezione: i pianeti che possiamo osservare sono

necessariamente molto grandi e molto vicini alla stella madre. Peraltro i

progressi in corso sono notevolissimi: si ritiene infatti che, per quanto

riguarda le stelle a noi piu’ vicine (entro un raggio di 100 anni luce,

corrispondenti a circa 6 miliardi di UA) siano ormai stati scoperti tutti i

pianeti giganti che distano meno di 2 Unità Astronomiche dalla stella madre.

La prossima frontiera della ricerca dei pianeti

extrasolari prevede missioni spaziali (Kepler, COROT, Space Interferometry

Mission e poi Darwin e Terrestrial Planet Finder) dedicate alla ricerca di

esopianeti di piccola massa e lo studio dettagliato delle loro proprietà’

chimiche, fisiche e geologiche. Tra gli scopi principali un vero e proprio

“Sacro Graal” della ricerca esoplanetaria: la scoperta di pianeti rocciosi

di massa simile alla Terra che orbitino alla distanza di circa una Unità

Astronomica dalla stella madre.

Stiamo da tempo scoprendo che la nostra posizione

nell’universo non e’ privilegiata sotto diversi punti di vista. Abbiamo

imparato in passato che la Terra non e’ in una posizione speciale, non e’ al

centro dell’universo. Poi abbiamo visto che neppure il Sole è al centro, ed

e’ solo una stella fra tante. Anche la nostra galassia e’ una fra tante,

immersa in un cosmo in continua espansione. L’inizio del nuovo millennio ci

sta offrendo altre nuove scoperte: pianeti sconosciuti, che orbitano attorno a

stelle aliene, ci dicono che Urano, Giove,

Saturno, Marte e la stessa Terra hanno dei fratelli cosmici, e che essi sono

numerosi, probabilmente numerosissimi. Una nuova rivoluzione copernicana.

Luglio 2005

Marco G. Giammarchi, Primo Ricercatore all'Ist. Naz. di Fisica Nucleare Marco.Giammarchi@mi.infn.it e Marco A. C. Potenza, Ricercatore all'Università agli Studi di Milano

ritorno a corrierebit - scienza

Bibliografia

1) G. Marcy et al., Observed

Properties of

Exoplanets: Masses, Orbits, and Metallicities. Astro-ph/0505003,

29 Aprile 2005.

2) http://exoplanets.org.